年末岁初,全球科技界最火爆的事件莫过于ChatGPT。

ChatGPT基于神经网络的自然语言处理技术,通过大量的语料训练,模拟人类的对话、思维和推理方式,以更加准确、自然和出色的用户体验,实现了与人类的快速互动交互。

ChatGPT的火爆,以及东数西算、数字化转型等应用的强劲增长,使得全球算力呈现供应紧张的现象;坊间传闻,英伟达(NVIDIA)的AI芯片供货已经排队到明年二季度,有人甚至把当下人工智能热度降温,归结于算力的供不应求。

算力就是生产力,数字基础设施的重要性也不言而喻。

那么,算力需求和缺口该如何填补?

其实,AI芯片主要分为图形处理器(GPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)、中央处理器(CPU)等类脑芯片四大类。面对强劲的算力需求,AI芯片作为算力的硬件基石,更需要多种AI芯片各司其职,共同协作。

今年6月份举办的“数据中心与AI技术首映”上,AMD在第四代EPYC(霄龙) CPU产品组合中增加两款新的工作负载优化处理器——Bergamo和Genoa-X,以及适用于生成式AI的下一代 AMD Instinct 产品。这无疑将大大缓解算力紧缺的局面,同时也会显著降低客户的投资成本和最终用户的使用成本。

为什么这么说呢?两年前,AMD曾宣布在2025年实现EPYC 处理器和AMD Instinct加速器能效提高30倍的目标,这些产品也将为运行在加速计算节点上的AI训练和高性能计算应用提供算力支持。

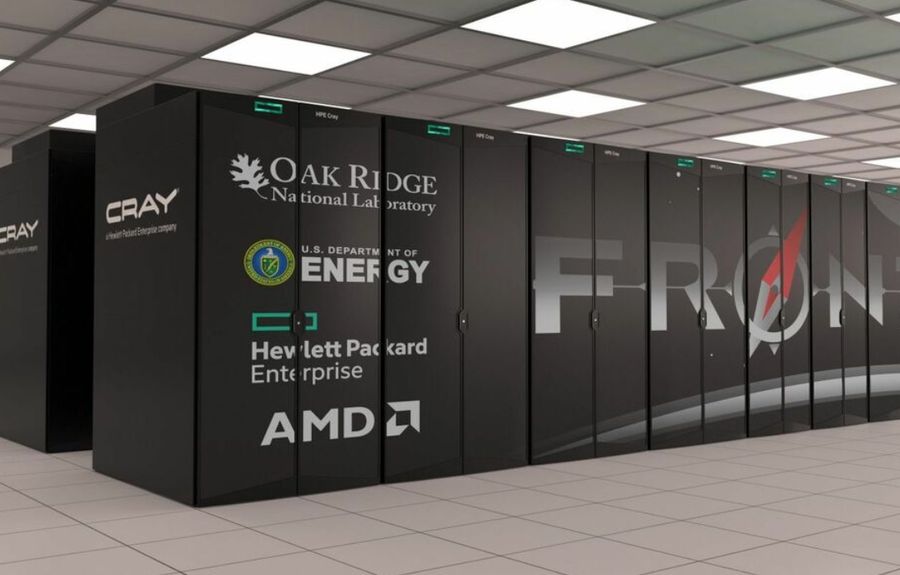

这不是空话,很多事例已经证明了这一点。例如,唯一投入实用的百亿亿次超算——“Frontier”,就使用了AMD的第三代EPYC 处理器及Instinct MI250X加速卡这对好拍档。EPYC、Instinct强强联手的同时,它们也是开放的,可以搭档友商的硬件来使用。

此外,峰值性能有望超过200亿亿次的超算预计将于明年在美国劳伦斯利弗莫尔国家实验室亮相。这款名称“EI Capitan”的超级计算机配备AMD第四代EPYC处理器(Genoa)和最新Instinct MI300A加速器。

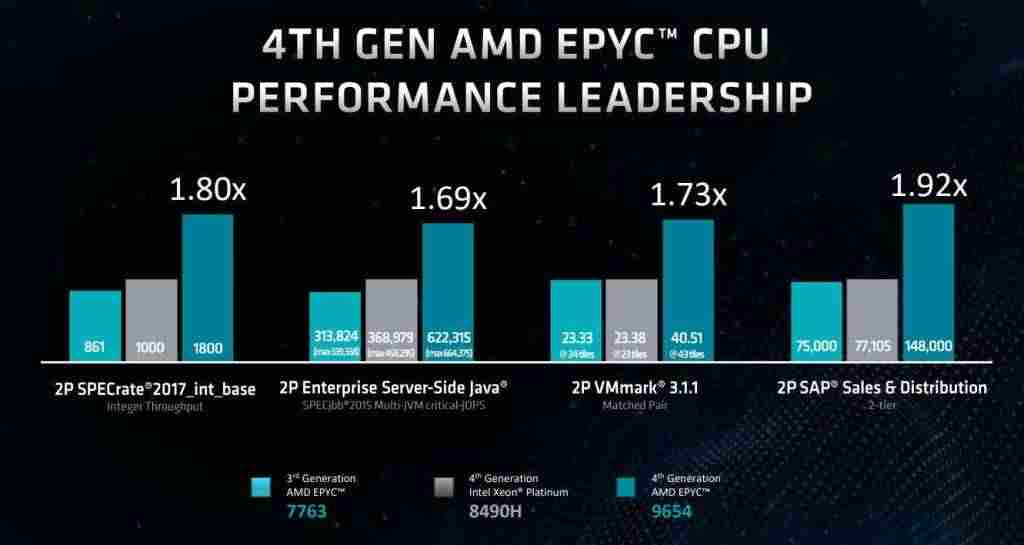

2022年11月AMD推出了基于chiplet打造的EPYC第四代处理器Genoa,其以最快的运行速度、出色的每插槽性能和每核心性能、超强的安全性、丰富的解决方案生态系统,为不同的工作负载提供领先的能源效率和最佳的TCO。

“以更少的投资,获取更多的价值。”AMD EPYC的这种领先优势一直延续至今。

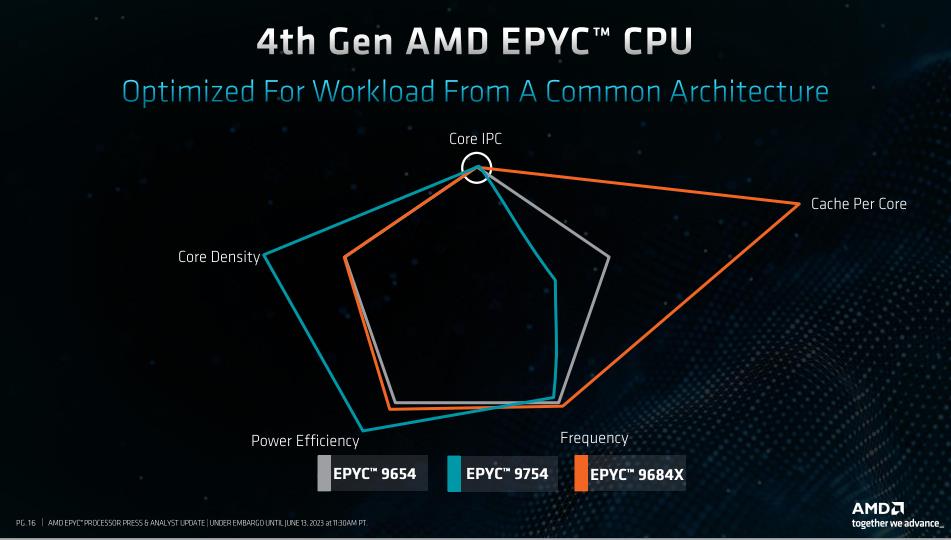

如今,第四代EPYC处理器还拥有了新的系列,分别是“Genoa-X”和“Bergamo”,还有即将发布的“Siena”。

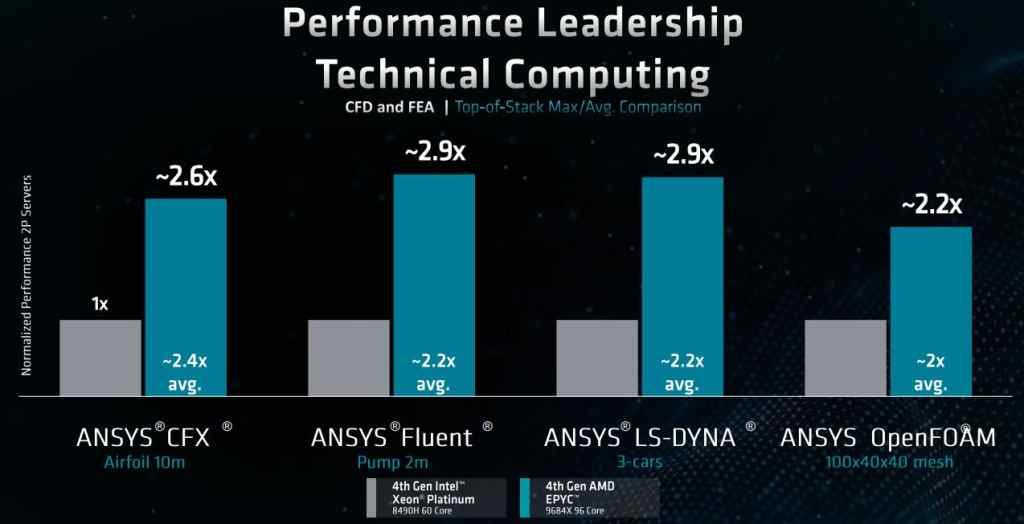

加载了AMD 3D V-Cache技术的“Genoa-X”,其采用的是5nm制程工艺的第四代Zen 4架构,比上一代Zen3架构能效高出62%,同等功耗下性能提升49%。通过3D V-Cache技术在每个CCD上额外堆叠64MB缓存,缓存总量高达1254MB,再辅以AMD Infinity、Guard安全性与更加丰富的解决方案生态,其性能大大提升,有效支持电子设计自动化相关的计算(EDA)、计算流体动力学(CFD)、有限元分析(FEA)和结构分析(SA)。

采用AMD 3D V-Cache的第四代AMD EPYC处理器Genoa-X 在Ansys CFX中每天可完成更多的设计任务,从而大幅加速产品开发;而运行ANSYS Fluent的性能最高达到了英特尔60核的Xeon Platinum 8490H处理器的2.9倍 有效模拟和优化产品外部空气动力学特征,促进客户改进产品外观、提高工作效率、节省能源消耗;在OpenFOAM的测试中最高也达到英特尔Xeon Platinum 8490H的2.2倍,这意味着技术计算工作负载可在更少计算节点上获得高性能表现,让用户可用更少的机器来获得更好的负载性能表现。

EPYC 97X4(Bergamo)系列处理器采用了Zen4c架构,它是AMD专门为云计算场景打造的一款CPU核心,与Zen4架构保持了相同的IPC性能和ISA指令集,通过在设计上的多项优化,使得核心面积大幅缩小,功耗效率大幅提升。Zen4c EPYC处理器搭载128个核心256个线程,超过了Zen4的96个核心192个线程。Bergaomo提供了可扩展性、灵活性、抗压性、速度、可视化,支持建模、简化部署和管理,是支持云原生开发与应用的得力武器。

Bergamo有三个版本:9754、9754S、9734,核心从112到128个,三级缓存均为256MB。其中EPYC 9754的同步多线程技术(SMT)可以配置——开启后可降低总体拥有成本。

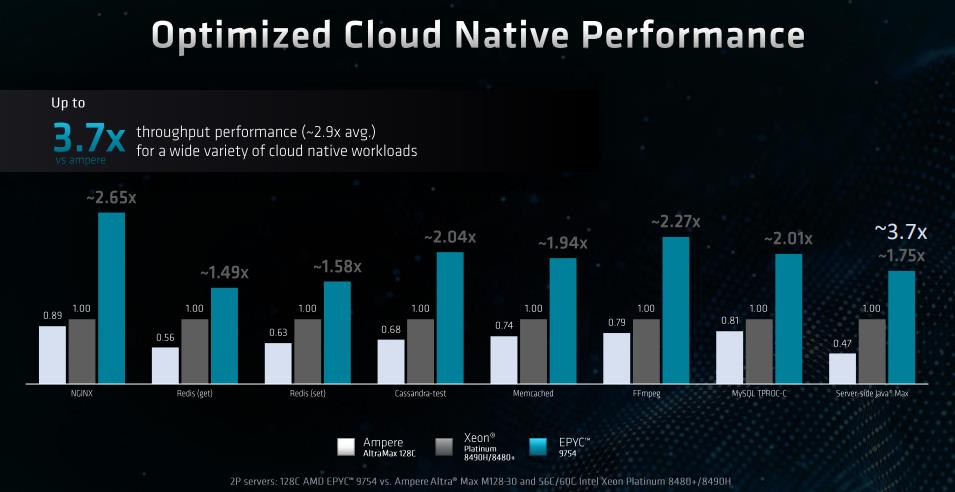

经过NGINX、Redis、Cassandra-test、Memcached、FFmpeg、MySQL TPROC-C、Server-side Java Max等平台运行测试,EPYC 9754的平均吞吐量、性能均数倍于友商。

要实现每秒处理3.75亿的实时需求,与128核的2P Ampere Altra相比,同核数的2P AMD EPYC 9754S可以节省55%的服务器数,年度节省39%的耗电量、39%的运营成本,最终减少19%的总体拥有成本。

最近,中国电子技术标准化研究院审查和公告后的2023年首轮CPUBench公开测试活动报告显示,搭载AMD EPYC 9754处理器的新华三UniServer R5500 G6Typical分数拿到了572.8的最好成绩。英特尔平台最好成绩排第四,基于Xeon Platinum 8490H处理器的新华三R6900G6成绩为449.1,比AMD最好成绩落后27.5%。

从第三代EPYC处理器开始,AMD的处理器产品线呈现出了多元化态势,第四代EPYC处理器更是根据市场做了细分,除了保持传统优势的通用型产品,还针对云原生应用、计算技术以及面向电信与边缘端演绎拓展,产品家族越来越丰富的同时,为客户需求提供更加精准的解决方案和服务,也为目前的算力困境提出了多种不同的产品组合,助力算力突围。

产品只是AMD面向从云端到边缘再到端点的全面应用支持的举措之一。AMD还在架构方面和生态系统合作伙伴携手打造经验证的开放式解决方案,应对全球算力面临的严峻挑战。

AMD不仅开发了大量软件及开源平台,同时也与合作伙伴紧密牵手,以适配更多的应用,支持更多的业务需求。

在巩固拓展EPYC处理器应用范围的同时,AMD的生态圈在不断扩大,目前已经拥有AWS、Oracle、ASUS、联想、戴尔、HPE、Supermicro、思科、谷歌云、微软Azure、腾讯云等大量的生态伙伴。

前不久,一家市场份额居国内前茅的服务器供应商,在其产品战略发布会期间向笔者透露,该公司生产的服务器中,采用EPYC处理器的数量占比接近30%。这是一个很了不起出的数字——两年前,这家公司的CEO亲口告诉笔者,公司只选择另外一家供应商的处理器。

看得出来,AMD EPYC已经成为当前市场上性能最为强劲的处理器,其以凭借先进的制程工艺、架构技术以及更多的核心、更高的频率,在整体综合性、多核整数性能、多核浮点性能都稳居前列;面向AI与未来计算领域,EPYC处理器用配置与测试结果说话, 方方面面“吊打”英特尔,也在AI算力竞赛中取得了先机。伴随AMD在技术、服务和生态等方面的不断突破,笔者相信,AMD EPYC处理器将在未来众多领域、尤其是AI算力领域,将扮演更为重要的角色。

AMD的成功之道,在于“创新”二字。要敢于创新,勇于创新。但创新并非易事,AMDEPYC的故事向我们展示:企业的成功并没有捷径,踏踏实实做产品才是王道。

- 联想中国区誓师大会召开,新财年力争两位数增长 – 2025年3月31日

- 欧定2025春夏新品发布会:东方千年工艺与现代科技融合,争夺高端商务服饰话语权 – 2025年3月30日

- 优刻得携手360,深度布局“DeepSeek一体机+大模型安全+ AI应用”合作 – 2025年3月28日